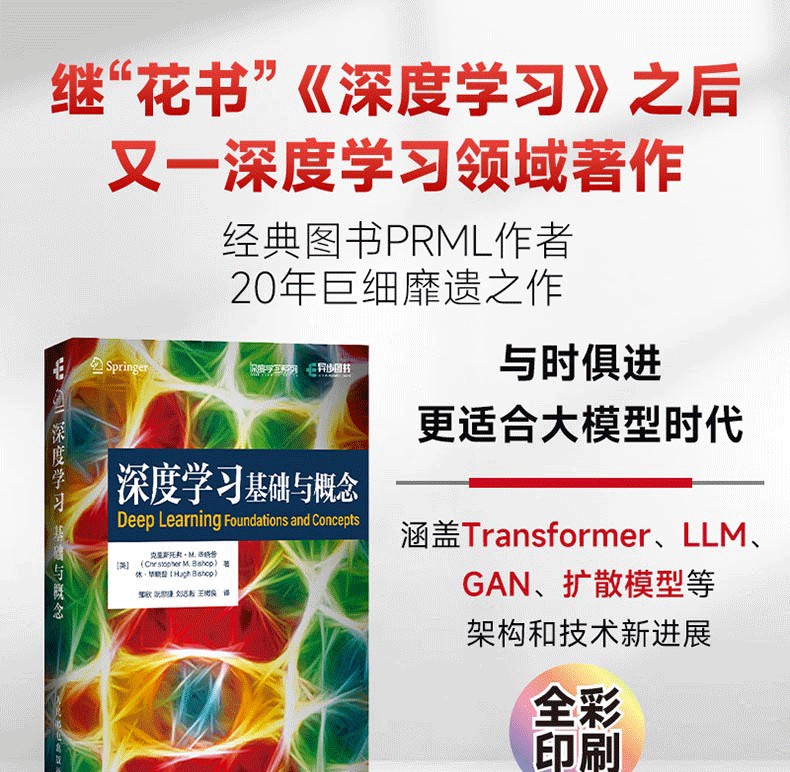

深度學習 基礎與概念

(英)克里斯多福‧M.畢曉普(Christopher M.Bishop),(英)休‧畢曉普(Hugh Bishop) 著 鄒欣 等 譯

出版社:人民郵電出版社

出版日期:2025/05/01

页 数:592

装 帧:平装

ISBN:9787115663702

內容簡介

本書全面且深入地呈現了深度學習領域的知識體系,系統梳理了該領域的核心知識,闡述了深度學習的關鍵概念、基礎理論及核心思想,剖析了當代深度學習架構與技術。

全書共20章。本書首先介紹深度學習的發展歷程、基本概念及其在諸多領域(如醫療診斷、圖像合成等)產生的深遠影響;繼而深入探討支撐深度學習的數學原理,包括概率、標準分佈等;在網絡模型方面,從單層網絡逐步深入到多層網絡、深度神經網絡,詳細講解其結構、功能、優化方法及其在分類、回歸等任務中的應用,同時涵蓋卷積網絡、Transformer 等前沿架構及其在計算機視覺、自然語言處理等領域的獨特作用。

本書還對正則化、採樣、潛變量、生成對抗網絡、自編碼器、擴散模型等關鍵技術展開深入分析,闡釋其原理、算法流程及實際應用場景。對於機器學習領域的新手,本書是全面且系統的入門教材,可引領其踏入深度學習的知識殿堂;對於機器學習領域從業者,本書是深化專業知識、緊跟技術前沿的有力工具;對於相關專業學生,本書是學習深度學習課程、開展學術研究的優質參考資料。無論是理論學習、實踐應用還是學術研究,本書都是讀者在深度學習領域探索與前行的重要指引。

作者介紹

克里斯托弗·M. 畢曉普(Christopher M. Bishop)

微軟公司技術研究員、微軟研究院科學智能中心(Microsoft Research AI4Science)負責人。劍橋達爾文學院院士、英國皇家工程院院士、愛丁堡皇家學會院士和倫敦皇家學會院士。曾出版經典著作《模式識別與機器學習》(Pattern Recognition and Machine Learning)。

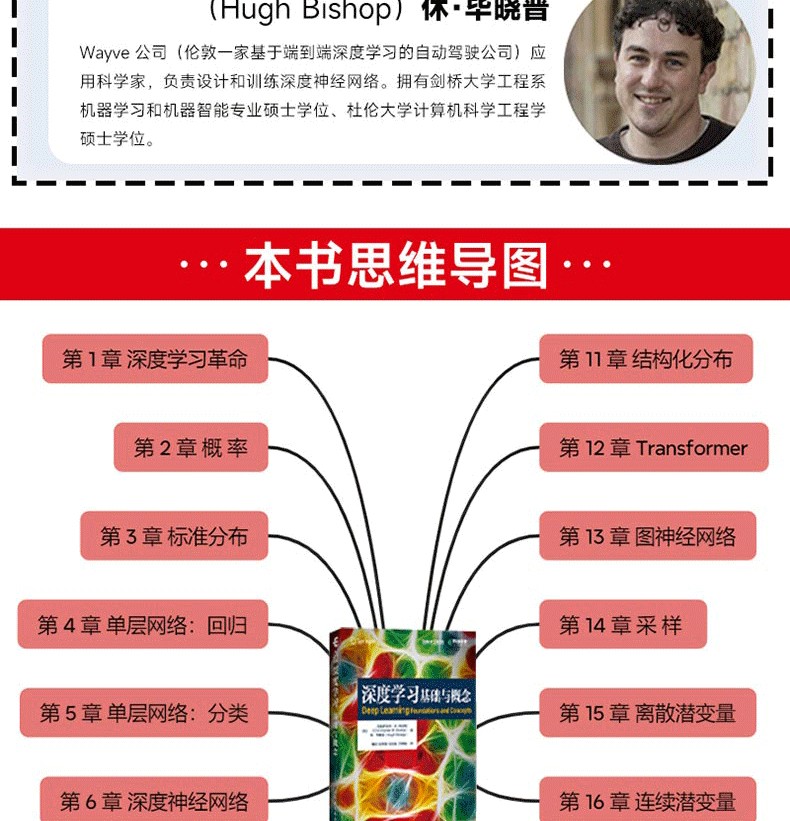

休·畢曉普(Hugh Bishop)

Wayve 公司(倫敦一家基於端到端深度學習的自動駕駛公司)應用科學家,負責設計和訓練深度神經網絡。擁有劍橋大學工程系機器學習和機器智能專業碩士學位、杜倫大學計算機科學工程學碩士學位。

目錄

第 1 章 深度學習革命 1

1 1 深度學習的影響 2

1 1 1 醫療診斷 2

1 1 2 蛋白質結構預測 3

1 1 3 圖像合成 4

1 1 4 大語言模型 5

1 2 一個教學範例 6

1 2 1 合成數據 7

1 2 2 線性模型 7

1 2 3 誤差函數 8

1 2 4 模型複雜度 8

1 2 5 正則化 11

1 2 6 模型選擇 12

1 3 機器學習簡史 14

1 3 1 單層網絡 15

1 3 2 反向傳播 16

1 3 3 深度網絡 17

第 2 章 概 率 21

2 1 機率法則 23

2 1 1 醫學篩查範例 23

2 1 2 加和法則與乘積法則 24

2 1 3 貝葉斯定理 26

2 1 4 再看醫學篩查範例 27

2 1 5 先驗機率與後驗機率 28

2 1 6 獨立變數 28

2 2 機率密度 28

2 2 1 分佈的範例 30

2 2 2 期望與協方差 31

2 3 高斯分佈 32

2 3 1 均值與變異數 32

2 3 2 似然函數 33

2 3 3 最大似然的偏差 35

2 3 4 線性回歸 36

2 4 密度變換 37

多元分佈 39

2 5 資訊論 40

2 5 1 熵 40

2 5 2 物理學視角 42

2 5 3 微分熵 43

2 5 4 最大熵 44

2 5 5 Kullback-Leibler 散度 45

2 5 6 條件熵 47

2 5 7 互資訊 47

2 6 貝葉斯機率 47

2 6 1 模型參數 48

2 6 2 正則化 49

2 6 3 貝葉斯機器學習 50

習題 50

第 3 章 標準分佈 55

3 1 離散變數 56

3 1 1 伯努利分佈 56

3 1 2 二項分佈 57

3 1 3 多項分佈 58

3 2 多元高斯分佈 59

3 2 1 高斯幾何 60

3 2 2 矩 62

3 2 3 限制 64

3 2 4 條件分佈 64

3 2 5 邊緣分佈 67

3 2 6 貝葉斯定理 70

3 2 7 最大似然 72

3 2 8 序貫估計 73

3 2 9 高斯混合 74

3 3 週期變數 76

馮米塞斯分佈 76

3 4 指數族分佈 80

充分統計量 84

3 5 非參數化方法 85

3 5 1 直方圖 85

3 5 2 核密度 86

3 5 3 最近鄰 88

習題 90

第 4 章 單層網:回歸 97

4 1 線性回歸 97

4 1 1 基函數 98

4 1 2 似然函數 100

4 1 3 最大似然 101

4 1 4 最小平方法的幾何表示 102

4 1 5 序貫學習 102

4 1 6 正則化最小平方法 103

4 1 7 多重輸出 104

4 2 決策理論 105

4 3 偏差 - 變異數權衡 108

習題 112

第 5 章 單層網:分類 115

5 1 判別函數 116

5 1 1 二分類 116

5 1 2 多分類 117

5 1 3 1-of-K 編碼方案 119

5 1 4 最小平方法分類 119

5 2 決策理論 121

5 2 1 誤分類率 122

5 2 2 預期損失 124

5 2 3 拒絕選項 125

5 2 4 推理與決策 125

5 2 5 分類器精度 128

5 2 6 ROC 曲線 129

5 3 生成分類器 131

5 3 1 連續輸入 132

5 3 2 最大似然解 134

5 3 3 離散特徵 136

5 3 4 指數族分佈 136

5 4 判別分類器 137

5 4 1 激活函數 137

5 4 2 固定基函數 138

5 4 3 邏輯斯諦回歸 139

5 4 4 多類邏輯斯諦回歸 140

5 4 5 probit 回歸 141

5 4 6 規範連接函數 143

習題 144

第 6 章 深度神經網絡 149

6 1 固定基函數的限制 150

6 1 1 維度詛咒 150

6 1 2 高維空間 152

6 1 3 數據流形 153

6 1 4 資料依賴的基底函數 155

6 2 多層網絡 156

6 2 1 參數矩陣 157

6 2 2 通用近似 158

6 2 3 隱藏單元激活函數 159

6 2 4 權重空間的對稱性 161

6 3 深度網絡 162

6 3 1 層次化表示 162

6 3 2 分佈式表示 163

6 3 3 表示學習 163

6 3 4 遷移學習 164

6 3 5 對比學習 165

6 3 6 通用網絡結構 168

6 3 7 張量 168

6 4 誤差函數 169

6 4 1 回歸 169

6 4 2 二分類 170

6 4 3 多分類 171

6 5 混合密度網絡 172

6 5 1 機器人運動學範例 172

6 5 2 條件混合分佈 173

6 5 3 梯度優化 175

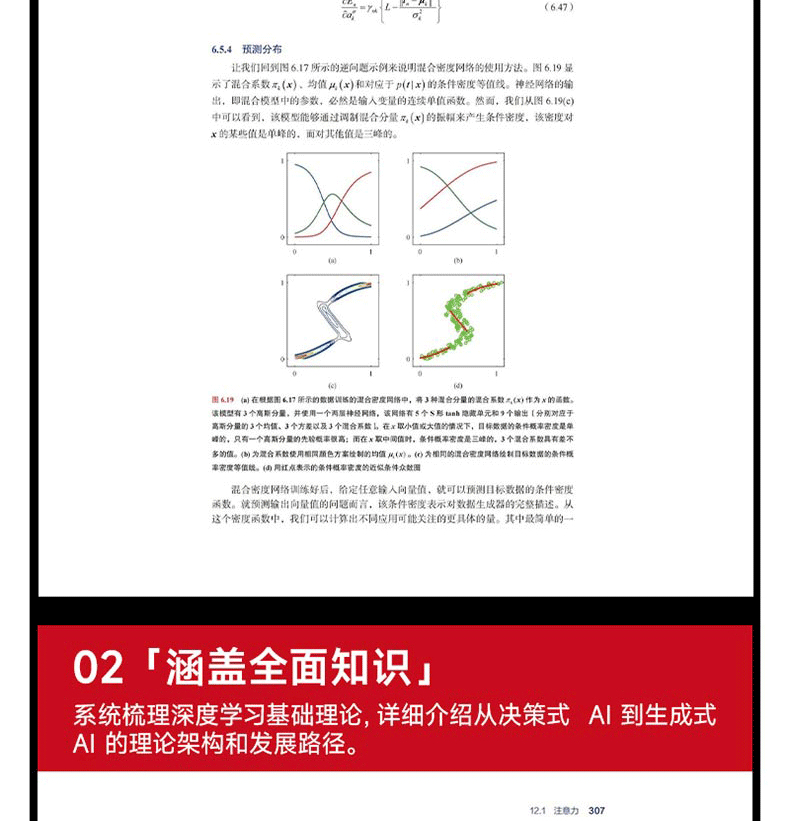

6 5 4 預測分佈 176

習題 177

第 7 章 梯度下降 181

7 1 錯誤平面 182

局部二次近似 183

7 2 梯度下降優化 184

7 2 1 梯度資訊的使用 185

7 2 2 批量梯度下降 185

7 2 3 隨機梯度下降 186

7 2 4 小批量方法 187

7 2 5 參數初始化 188

7 3 收斂 189

7 3 1 動量 190

7 3 2 學習率調度 192

7 3 3 AdaGrad、RMSProp 與 Adam 演算法 193

7 4 正則化 195

7 4 1 數據歸一化 195

7 4 2 批量歸一化 196

7 4 3 層歸一化 197

習題 198

第 8 章 反向傳播 201

8 1 梯度計算 202

8 1 1 單層網絡 202

8 1 2 一般前饋網絡 202

8 1 3 簡單範例 205

8 1 4 數值微分法 206

8 1 5 雅可比矩陣 207

8 1 6 黑塞矩陣 209

8 2 自動微分法 211

8 2 1 前向模式自動微分 213

8 2 2 逆模式自動微分 215

習題 217

第 9 章 正則化 219

9 1 歸納偏置 220

9 1 1 逆問題 220

9 1 2 無免費午餐定理 221

9 1 3 對稱性與不變性 222

9 1 4 等變性 224

9 2 權重衰減 225

9 2 1 一致性正則化項 226

9 2 2 廣義權重衰減 228

9 3 學習曲線 230

9 3 1 早停法 230

9 3 2 雙重下降 231

9 4 參數共享 234

軟權重共享 234

9 5 殘差連接 236

9 6 模型平均 239

dropout 241

習題 243

第 10 章 卷積網絡 247

10 1 計算機視覺 248

圖像數據 248

10 2 卷積濾波器 249

10 2 1 特徵檢測器 250

10 2 2 平移等變性 251

10 2 3 填充 252

10 2 4 跨步卷積 253

10 2 5 多維卷積 253

10 2 6 池化 255

10 2 7 多層卷積 256

10 2 8 網絡架構範例 257

10 3 可視化訓練好的 CNN 259

10 3 1 視覺皮層 259

10 3 2 可視化訓練好的濾波器 260

10 3 3 顯著性圖 262

10 3 4 對抗攻擊 263

10 3 5 合成圖像 264

10 4 目標檢測 265

10 4 1 邊界框 265

10 4 2 交並比 266

10 4 3 滑動視窗 267

10 4 4 跨尺度檢測 268

10 4 5 非最大抑制 269

10 4 6 快速區域卷積神經網絡 270

10 5 圖像分割 270

10 5 1 卷積分割 270

10 5 2 上採樣 271

10 5 3 全卷積網絡 272

10 5 4 U-Net 架構 273

10 6 風格遷移 274

習題 275

第 11 章 結構化分佈 279

11 1 機率圖模型 280

11 1 1 有向圖 280

11 1 2 分解 280

11 1 3 離散變數 282

11 1 4 高斯變量 284

11 1 5 二元分類器 286

11 1 6 參數和觀測值 287

11 1 7 貝葉斯定理 288

11 2 條件獨立性 289

11 2 1 3 個範例圖 289

11 2 2 相消解釋 292

11 2 3 d 分離 293

11 2 4 樸素貝葉斯 294

11 2 5 生成式模型 296

11 2 6 馬可夫毯 297

11 2 7 作為過濾器的圖 298

11 3 序列模型 299

潛變量 301

習題 302

第 12 章 Transformer 305

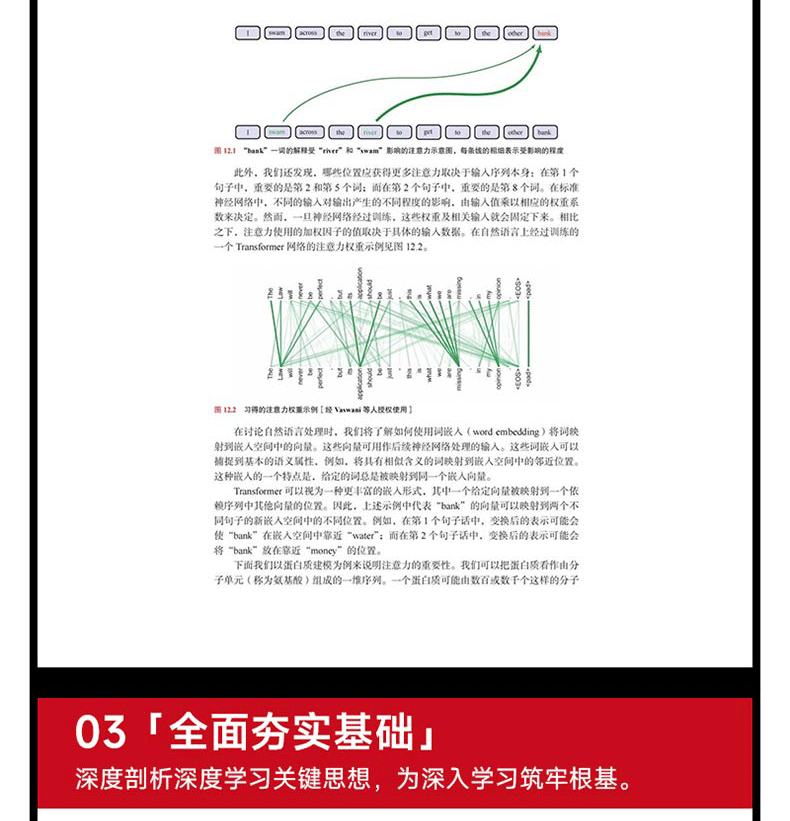

12 1 注意力 306

12 1 1 Transformer 處理 308

12 1 2 注意力係數 308

12 1 3 自註意力 309

12 1 4 網絡參數 310

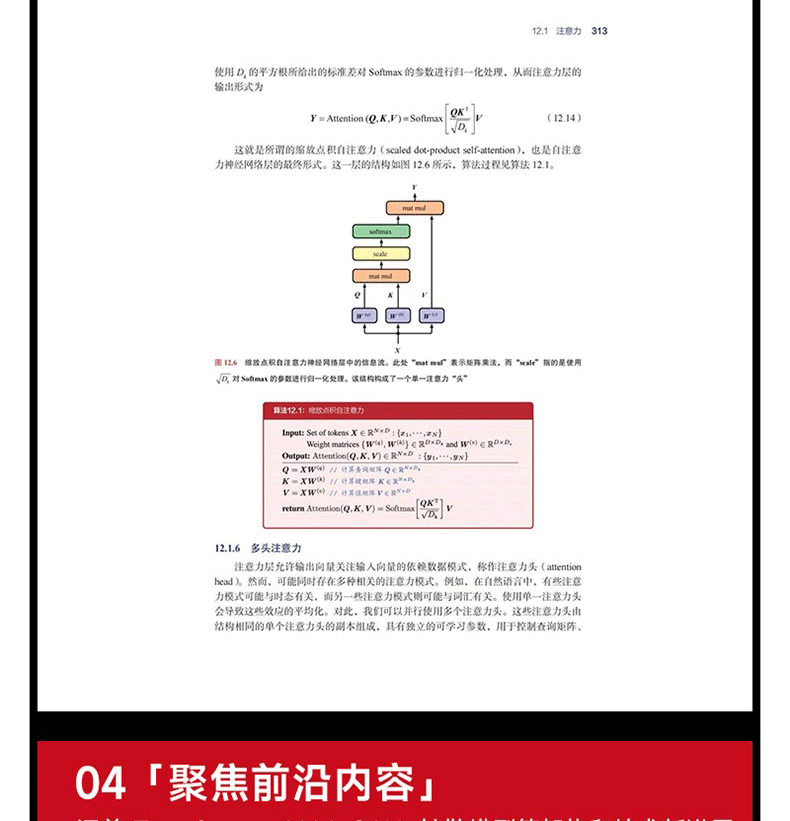

12 1 5 縮放自註意力 312

12 1 6 多頭注意力 313

12 1 7 Transformer 層 315

12 1 8 計算複雜度 316

12 1 9 位置編碼 317

12 2 自然語言 319

12 2 1 詞嵌入 320

12 2 2 分詞 321

12 2 3 詞袋模型 322

12 2 4 自回歸模型 323

12 2 5 遞歸神經網絡 324

12 2 6 通過時間的反向傳播 325

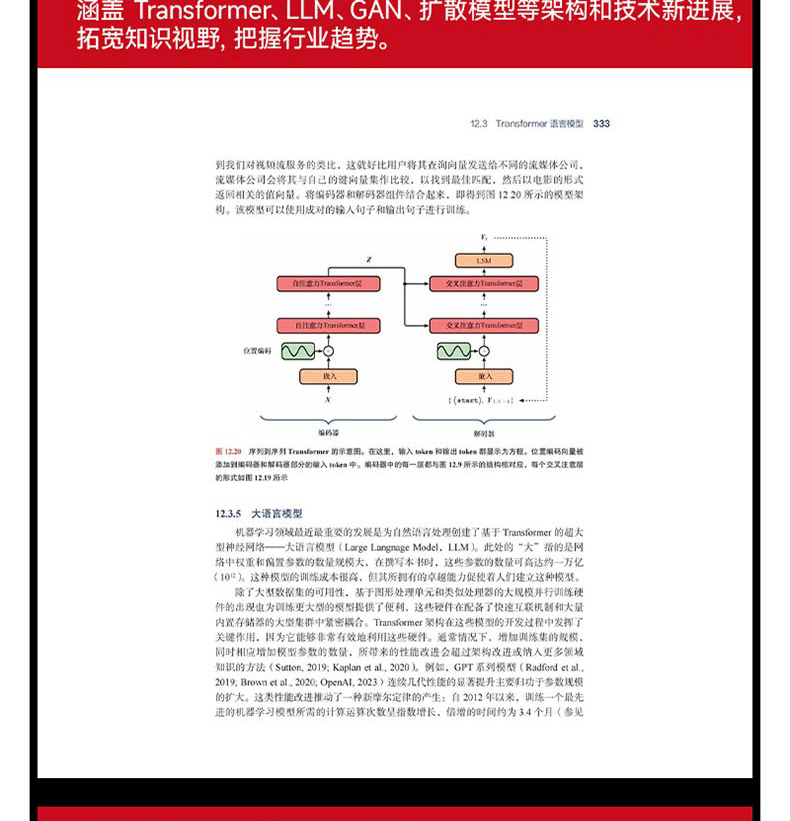

12 3 Transformer 語言模型 326

12 3 1 解碼器型 Transformer 326

12 3 2 抽樣策略 329

12 3 3 編碼器型 Transformer 330

12 3 4 序列到序列 Transformer 332

12 3 5 大語言模型 333

12 4 多模態 Transformer 336

12 4 1 視覺 Transformer 336

12 4 2 圖像生成 Transformer 337

12 4 3 音頻數據 339

12 4 4 文字語音轉換 340

12 4 5 視覺與語言 Transformer 342

習題 343

第 13 章 圖神經網絡 347

13 1 基於圖的機器學習 348

13 1 1 圖的屬性 349

13 1 2 鄰接矩陣 349

13 1 3 排列等變性 350

13 2 神經訊息傳遞 351

13 2 1 卷積濾波器 352

13 2 2 圖卷積網絡 353

13 2 3 聚合算子 354

13 2 4 更新算子 356

13 2 5 節點分類 357

13 2 6 邊分類 358

13 2 7 圖分類 358

13 3 通用圖網絡 359

13 3 1 圖注意力網絡 359

13 3 2 邊嵌入 360

13 3 3 圖嵌入 360

13 3 4 過度平滑 361

13 3 5 正則化 362

13 3 6 幾何深度學習 362

習題 363

第 14 章 採 樣 365

14 1 基本採樣 366

14 1 1 期望 366

14 1 2 標準分佈 367

14 1 3 拒絕採樣 369

14 1 4 適應性拒絕取樣 370

14 1 5 重要性採樣 371

14 1 6 採樣 - 重要性 - 重採樣 373

14 2 馬爾可夫鏈蒙特卡羅採樣 374

14 2 1 Metropolis 演算法 375

14 2 2 馬可夫鏈 376

14 2 3 Metropolis-Hastings 演算法 378

14 2 4 吉布斯採樣 380

14 2 5 祖先取樣 382

14 3 郎之萬採樣 383

14 3 1 基於能量的模型 384

14 3 2 最大化似然 385

14 3 3 朗之萬動力學 386

習題 388

第 15 章 離散潛變數 391

15 1 K 均值聚類 392

圖像分割 395

15 2 高斯混合分佈 397

15 2 1 似然函數 399

15 2 2 最大似然 400

15 3 EM 演算法 404

15 3 1 高斯混合模型 406

15 3 2 EM 演算法與K 均值演算法的關係 408

15 3 3混合伯努利分佈 409

15 4 證據下界 412

15 4 1 EM 算法回顧 413

15 4 2 獨立同分佈數據 415

15 4 3 參數先驗 415

15 4 4 廣義 EM 算法 416

15 4 5 順序 EM 算法 416

習題 417

第 16 章 連續潛變量 421

16 1 主成分分析 422

16 1 1 最大方差表述 423

16 1 2 最小誤差表述 424

16 1 3 數據壓縮 427

16 1 4 數據白化 428

16 1 5 高維數據 429

16 2 概率潛變量 430

16 2 1 生成式模型 431

16 2 2 似然函數 432

16 2 3 最大似然法 433

16 2 4 因子分析 436

16 2 5 獨立成分分析 437

16 2 6 卡爾曼濾波器 439

16 3 證據下界 439

16 3 1 EM 算法 441

16 3 2 PCA 的 EM 算法 442

16 3 3 因子分析的 EM 算法 444

16 4 非線性潛變量模型 444

16 4 1 非線性流形 445

16 4 2 似然函數 447

16 4 3 離散數據 448

16 4 4 構建生成式模型的 4 種方法 448

習題 449

第 17 章 生成對抗網絡 453

17 1 對抗訓練 454

17 1 1 損失函數 455

17 1 2 實戰中的 GAN 訓練 456

17 2 圖像的生成對抗網絡 458

CycleGAN 459

習題 462

第 18 章 標準化流 465

18 1 耦合流 467

18 2 自回歸流 470

18 3 連續流 472

18 3 1 神經 ODE 472

18 3 2 神經 ODE 的反向傳播 473

18 3 3 神經 ODE 流 474

習題 476

第 19 章 自編碼器 479

19 1 確定性的自編碼器 480

19 1 1 線性自編碼器 480

19 1 2 深度自編碼器 481

19 1 3 稀疏自編碼器 482

19 1 4 去噪自編碼器 482

19 1 5 掩蔽自編碼器 483

19 2 變分自編碼器 484

19 2 1 攤銷推理 487

19 2 2 重參數化技巧 488

習題 491

第 20 章 擴散模型 493

20 1 前向編碼器 494

20 1 1 擴散核 495

20 1 2 條件分佈 496

20 2 反向解碼器 497

20 2 1 訓練解碼器 499

20 2 2 證據下界 499

20 2 3 重寫 ELBO 501

20 2 4 預測噪聲 502

20 2 5 生成新的樣本 504

20 3 得分匹配 505

20 3 1 得分損失函數 506

20 3 2 修改得分損失 506

20 3 3 噪聲方差 508

20 3 4 隨機微分方程 508

20 4 有引導的擴散 509

20 4 1 有分類器的引導 510

20 4 2 無分類器的引導 510

習題 513

附 錄 517

附錄 A 線性代數 517

A 1 矩陣恒等式 517

A 2 跡和行列式 518

A 3 矩陣導數 519

A 4 特徵向量 521

附錄 B 變分法 524

附錄 C 拉格朗日乘子 526

參考資料 529

索 引 549

動手學深度學習(PyTorch版)

ISBN13:9787115600820

出版社:人民郵電出版社

作者:阿斯頓‧張等

出版日:2025/03/01

裝訂/頁數:平裝/572頁

規格:24cm*17cm (高/寬)

版次:一版

編輯推薦

深度學習領域重磅作品《動手學深度學習》重磅推出PyTorch版本;

李沐、阿斯頓·張等大咖作者強強聯合,精心編撰;

全球400多所大學採用的教科書,提供視頻課程、教學PPT、習題,方便教師授課與學生自學;

能運行、可討論的深度學習入門書,可在線運行源碼並與作譯者實時討論。

內容介紹

本書是《動手學深度學習》的重磅升級版本,選用經典的PyTorch深度學習框架,旨在向讀者交付更為便捷的有關深度學習的交互式學習體驗。

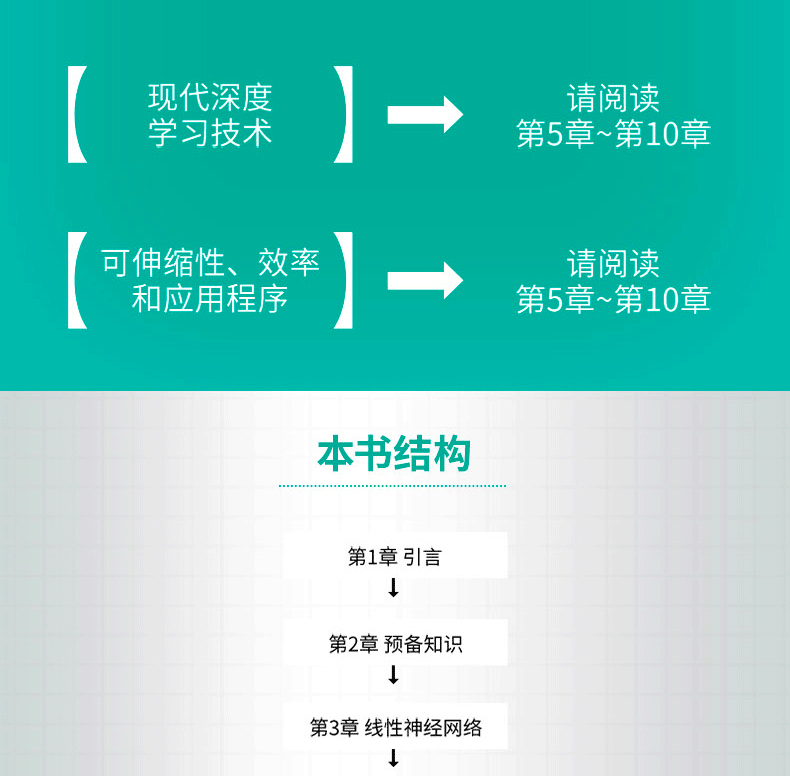

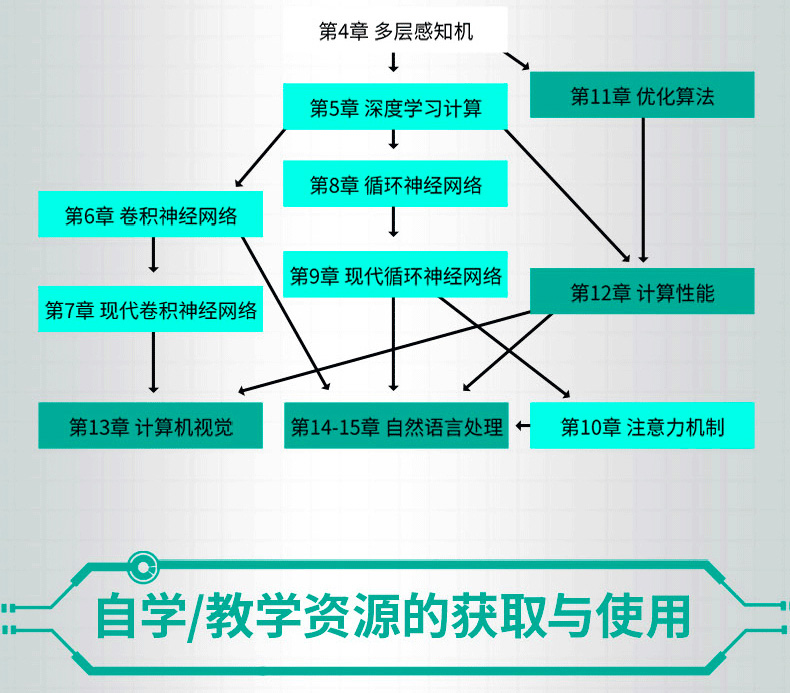

本書重新修訂《動手學深度學習》的所有內容,並針對技術的發展,新增注意力機制、預訓練等內容。本書包含15章,第一部分介紹深度學習的基礎知識和預備知識,並由線性模型引出最簡單的神經網絡――多層感知機;第二部分闡述深度學習計算的關鍵組件、卷積神經網絡、循環神經網絡、注意力機制等大多數現代深度學習應用背後的基本工具;第三部分討論深度學習中常用的優化算法和影響深度學習計算性能的重要因素,並分別列舉深度學習在計算機視覺和自然語言處理中的重要應用。

本書同時覆蓋深度學習的方法和實踐,主要面向在校大學生、技術人員和研究人員。閱讀本書需要讀者瞭解基本的Python編程知識及預備知識中描述的線性代數、微分和概率等基礎知識。

作者簡介

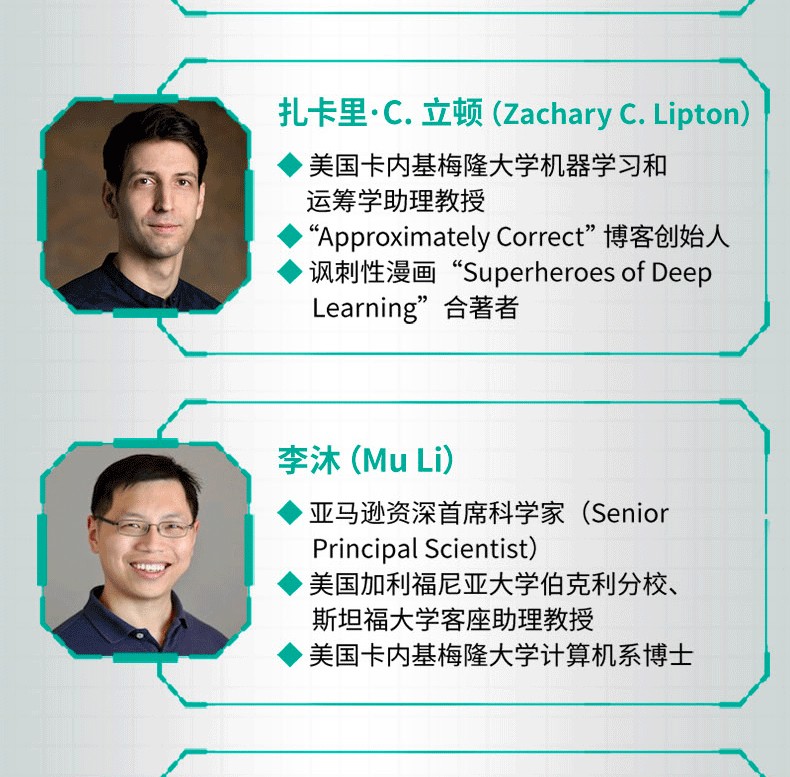

阿斯頓·張(Aston Zhang),亞馬遜資深科學家,美國伊利諾伊大學香檳分校計算機科學博士,統計學和計算機科學雙碩士。他專注於機器學習和自然語言處理的研究,榮獲深度學習國際頂級學術會議ICLR杰出論文獎、ACM UbiComp杰出論文獎以及ACM SenSys最佳論文獎提名。他擔任過EMNLP領域主席和AAAI資深程序委員。

扎卡裡·C. 立頓(Zachary C. Lipton),美國卡內基梅隆大學機器學習和運籌學助理教授,並在海因茨公共政策學院以及軟件和社會系統系擔任禮節性任命。他領導著近似正確機器智能(ACMI)實驗室,研究涉及核心機器學習方法、其社會影響以及包括臨床醫學和自然語言處理在內的各種應用領域。他目前的研究重點包括處理各種因果結構下分布變化的穩健和自適應算法、超越預測為決策提供信息(包括應對已部署模型的戰略響應)、醫學診斷和預後預測、算法公平性和可解釋性的基礎。他是“Approximately Correct”博客的創始人,也是諷刺性漫畫“Superheroes of Deep Learning”的合著者。

李沐(Mu Li),亞馬遜資深首席科學家(Senior Principal Scientist),美國加利福尼亞大學伯克利分校、斯坦福大學客座助理教授,美國卡內基梅隆大學計算機系博士。他曾任機器學習創業公司Marianas Labs的CTO和百度深度學習研究院的主任研發架構師。他專注於機器學習系統和機器學習算法的研究。他在理論與應用、機器學習與操作系統等多個領域的頂級學術會議上發表過論文,被引用上萬次。

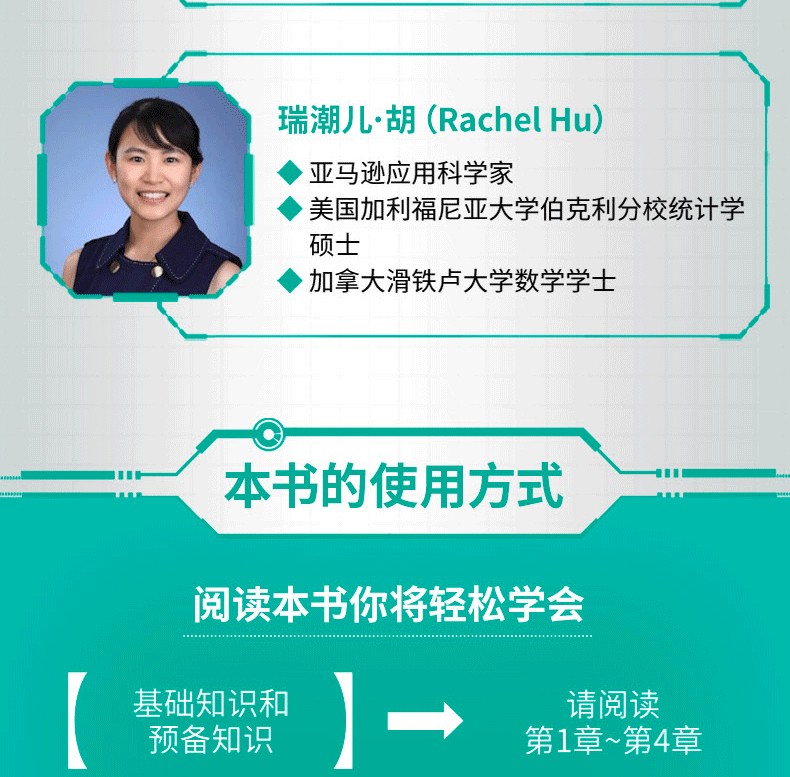

亞歷山大·J. 斯莫拉(Alexander J. Smola),亞馬遜副總裁/杰出科學家,德國柏林工業大學計算機科學博士。他曾在澳大利亞國立大學、美國加利福尼亞大學伯克利分校和卡內基梅隆大學任教。他發表過超過300篇學術論文,並著有5本書,其論文及書被引用超過15萬次。他的研究興趣包括深度學習、貝葉斯非參數、核方法、統計建模和可擴展算法。

目錄

對本書的讚譽

前言

譯者簡介

學習環境配置

資源與支持

主要符號表

章 引言 1

1.1 日常生活中的機器學習 2

1.2 機器學習中的關鍵組件 3

1.2.1 資料 3

1.2.2 模型 4

1.2.3 目標函數 4

1.2.4 優化演算法 5

1.3 各種機器學習問題 5

1.3.1 監督學習 5

1.3.2 無監督學習 11

1.3.3 與環境互動 11

1.3.4 強化學習 12

1.4 起源 13

1.5 深度學習的發展 15

1.6 深度學習的成功案例 16

1.7 特點 17

第 2章 預備知識 20

2.1 資料操作 20

2.1.1 入門 21

2.1.2 運算子 22

2.1.3 廣播機制 23

2.1.4 索引和切片 24

2.1.5 節省記憶體 24

2.1.6 轉換為其他Python物件 25

2.2 資料預處理 26

2.2.1 讀取資料集 26

2.2.2 處理缺失值 26

2.2.3 轉換為張量格式 27

2.3 線性代數 27

2.3.1 標量 28

2.3.2 向量 28

2.3.3 矩陣 29

2.3.4 張量 30

2.3.5 張量演算法的基本性質 31

2.3.6 降維 32

2.3.7 點積 33

2.3.8 矩陣-向量積 33

2.3.9 矩陣-矩陣乘法 34

2.3.10 範數 35

2.3.11 關於線性代數的更多資訊 36

2.4 微積分 37

2.4.1 導數和微分 37

2.4.2 偏導數 40

2.4.3 梯度 41

2.4.4 鍊式法則 41

2.5 自動微分 42

2.5.1 一個簡單的例子 42

2.5.2 非標量變數的反向傳播 43

2.5.3 分離計算 43

2.5.4 Python控制流的梯度計算 44

2.6 機率 44

2.6.1 基本機率論 45

2.6.2 處理多個隨機變數 48

2.6.3 期望與變異數 50

2.7 查閱文檔 51

2.7.1 查找模組中的所有函數和類別 51

2.7.2 找出特定函數和類別的用法 52

第3章 線性神經網路 54

3.1 線性迴歸 54

3.1.1 線性迴歸的基本元素 54

3.1.2 向量化加速 57

3.1.3 常態分佈與平方損失 58

3.1.4 從線性迴歸到深度網路 60

3.2 線性迴歸的從零開始實現 61

3.2.1 生成資料集 62

3.2.2 讀取資料集 63

3.2.3 初始化模型參數 63

3.2.4 定義模型 64

3.2.5 定義損失函數 64

3.2.6 定義最佳化演算法 64

3.2.7 訓練 64

3.3 線性迴歸的簡潔實作 66

3.3.1 生成資料集 66

3.3.2 讀取資料集 66

3.3.3 定義模型 67

3.3.4 初始化模型參數 67

3.3.5 定義損失函數 68

3.3.6 定義最佳化演算法 68

3.3.7 訓練 68

3.4 softmax回歸 69

3.4.1 分類問題 69

3.4.2 網路架構 70

3.4.3 全連接層的參數開銷 70

3.4.4 softmax運算 71

3.4.5 小批量樣本的向量化 71

3.4.6 損失函數 72

3.4.7 資訊理論基礎 73

3.4.8 模型預測與評估 74

3.5 影像分類資料集 74

3.5.1 讀取資料集 75

3.5.2 讀取小批量 76

3.5.3 整合所有元件 76

3.6 softmax回歸的從零開始實作 77

3.6.1 初始化模型參數 77

3.6.2 定義softmax操作 78

3.6.3 定義模型 78

3.6.4 定義損失函數 79

3.6.5 分類精度 79

3.6.6 訓練 80

3.6.7 預測 82

3.7 softmax回歸的簡潔實作 83

3.7.1 初始化模型參數 83

3.7.2 重新檢視softmax的實作 84

3.7.3 優化演算法 84

3.7.4 訓練 84

第4章 多層感知機 86

4.1 多層感知機 86

4.2 多層感知機的從零開始實現 92

4.3 多層感知機的簡潔實現 94

模型 94

4.4 模型選擇、欠擬合與過擬合 95

4.5 權重衰減 103

4.6 暫退法 108

4.7 前向傳播、反向傳播與計算圖 112

4.8 數值穩定性與模型初始化 115

4.9 環境與分佈偏移 119

4.10 實戰Kaggle比賽:預測房價 127

第5章 深度學習計算 136

5.1 層和塊 136

5.2 參數管理 141

5.3 延後初始化 145

實例化網路 146

5.4 自訂圖層 146

5.5 讀寫文件 148

5.6 GPU 150

第6章 卷積神經網路 155

6.1 從全連接層到卷積 155

6.2 影像卷積 159

6.3 填充和步幅 164

6.4 多輸入多輸出通道 166

6.5 匯聚層 170

6.6 卷積神經網路(LeNet) 173

第7章 現代卷積神經網路 178

7.1 深度卷積神經網路(AlexNet) 178

7.2 使用區塊的網路(VGG) 184

7.3 網絡中的網絡(NiN) 187

7.4 含並行連接的網路(GoogLeNet) 190

7.5 批量規範化 194

7.6 殘差網路(ResNet) 200

7.7 稠密連接網路(DenseNet) 205

第8章 循環神經網路 209

8.1 序列模型 209

8.2 文本預處理 216

8.3 語言模型與資料集 219

8.4 循環神經網路 226

8.5 循環神經網路的從零開始實現 230

8.6 循環神經網路的簡潔實作 237

8.7 透過時間反向傳播 239

第9章 現代循環神經網路 244

9.1 門控循環單元(GRU) 244

9.2 長短期記憶網絡(LSTM) 249

9.3 深度循環神經網路 254

9.4 雙向循環神經網路 256

9.5 機器翻譯與資料集 260

9.6 編碼器-解碼器架構 265

9.7 序列到序列學習(seq2seq) 267

9.8 束搜尋 275

0章 注意力機制 278

10.1 注意力提示 278

10.2 注意力匯聚:Nadaraya-Watso核回歸 281

10.3 注意力評分函數 287

10.4 Bahdanau 注意力 291

10.5 多頭注意力 295

10.6 自註意力與位置編碼 298

10.7 Transformer 302

1章 優化演算法 311

11.1 優化與深度學習 311

11.2 凸性 315

11.3 梯度下降 322

11.4 隨機梯度下降 329

11.5 小批量隨機梯度下降 334

11.6 動量法 341

11.7 AdaGrad演算法 348

11.8 RMSProp演算法 353

11.9 Adadelta演算法 356

11.10 Adam演算法 358

11.11 學習率調度器 361

2章 計算性能 369

12.1 編譯器和解釋者 369

12.2 異步計算 372

透過後端異步處理 373

12.3 自動並行 375

12.4 硬體 378

12.5 多GPU訓練 388

12.6 多GPU的簡潔實作 394

12.7 參數伺服器 397

3章 計算機視覺 404

13.1 影像增廣 404

13.2 微調 410

13.3 目標偵測與邊界框 415

13.4 錨框 417

13.5 多尺度目標偵測 427

13.6 目標偵測資料集 430

13.7 單發多框偵測(SSD) 433

13.8 區域卷積神經網路(R-CNN)系列 441

13.9 語意分割與資料集 445

13.10 轉置卷積 450

13.11 全卷積網 453

13.12 風格遷移 458

13.13 實戰 Kaggle競賽:影像分類(CIFAR-10) 464

13.14 實戰Kaggle競賽:狗的品種辨識(ImageNet Dogs) 470

4章 自然語言處理:預訓練 476

14.1 詞嵌入(word2vec) 477

14.2 近似訓練 480

14.3 用於預訓練詞嵌入的資料集 482

14.4 預訓練word2vec 488

14.5 全域向量的詞嵌入(GloVe) 491

14.6 子詞嵌入 494

14.7 詞的相似度與類比任務 497

14.8 來自Transformer的雙向編碼器表示(BERT) 500

14.9 用於預訓練BERT的資料集 507

14.10 預訓練BERT 512

5章 自然語言處理:應用 515

15.1 情感分析及資料集 516

15.2 情緒分析:使用循環神經網路 518

15.3 情緒分析:使用卷積神經網路 521

15.4 自然語言推論與資料集 526

15.5 自然語言推論:使用注意力 530

15.6 針對序列級和詞元級應用微調BERT 535

15.7 自然語言推論:微調BERT 538

附錄A 深度學習工具 543

A.1 使用Jupyter記事本 543

A.1.1 在本機編輯與執行程式碼 543

A.1.2 進階選項 545

A.2 使用AmazoSageMaker 546

A.2.1 註冊 547

A.2.2 建立SageMaker實例 547

A.2.3 運轉與停止實例 548

A.2.4 更新Notebook 548

A.3 使用AmazoEC2實例 549

A.3.1 建立與執行EC2實例 549

A.3.2 安裝CUDA 553

A.3.3 安裝庫以運行程式碼 553

A.3.4 遠端運行Jupyter記事本 554

A.3.5 關閉未使用的實例 554

A.4 選擇伺服器和GPU 555

A.4.1 選擇伺服器 555

A.4.2 選擇GPU 556

A.5 為本書做出貢獻 558

A.5.1 提交微小更改 558

A.5.2 大量文字或程式碼修改 559

A.5.3 提交主要更改 559

參考文獻 562